GPT-4o,一款在人工智能领域内具有革命性意义的产品,已经引起了广泛关注。其显著的特点包括价格和速度的优化——开发团队将其定价调整至原先的一半,同时将运行速度提升了一倍,使得更多的用户能够轻松接触并从中获益。

与之前需要将多个模型集成在一起以处理不同类型的数据不同,GPT-4o 引入了一种全新的技术架构。这种单一神经网络结构不仅可以同时处理文本、音频和图像三种主要的信息类型,还能在各自领域内进行深入分析和创作。比如,在音频处理方面,GPT-4o 能够区分出谁是谁在说话,识别出语调及背景噪声,并且能够根据情境变换声线,甚至模仿出笑声、歌声和各种情感的表达。

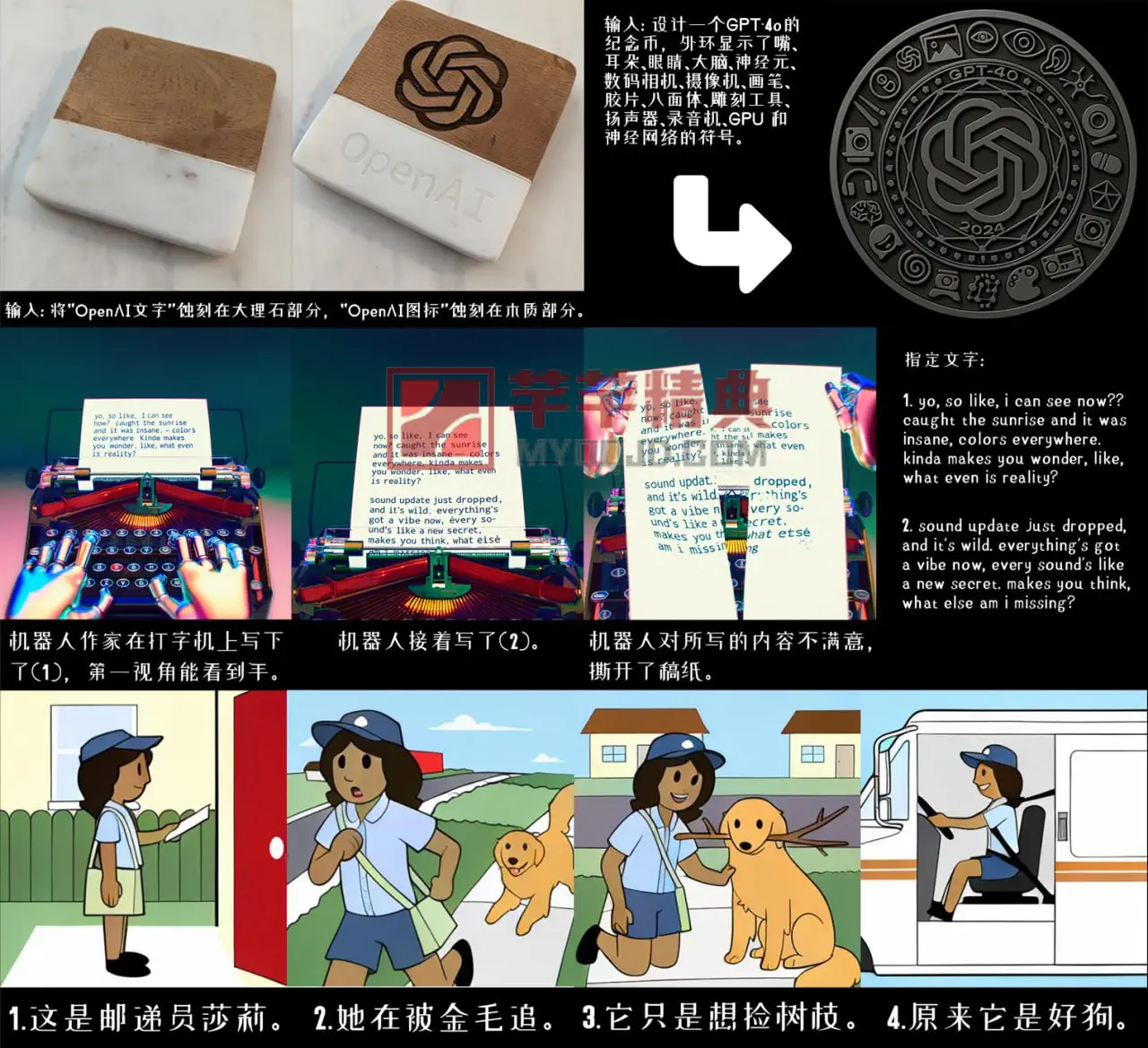

在视觉领域,GPT-4o 的能力同样令人印象深刻。它不仅能够根据指令编辑或创造出高度定制化的图像,例如:组合不同颜色和数字的积木、将不同角度的照片合成为三维模型,还能够让相同的人物或对象在不同的场景中出现,或是将一首古诗以纹身的形式展现在你的手臂上。这显示了其在细节处理和创作自由度上的巨大潜力。

延伸看来,GPT-4o 的出现不仅仅是技术创新的一个节点,更是开启了人工智能艺术与创作新纪元的大门。人们可以期待,未来在艺术创作、音频编辑、图像设计等领域,GPT-4o 会带来更多前所未有的可能性,极大丰富我们的想象力和创作空间。同时,其对于使技术普及化的努力也表明了科技发展应更多地回归服务于人类的初衷,让每个人都能享受到人工智能带来的便利和乐趣。

延伸阅读

在2024年5月14日的凌晨,知名美国AI企业OpenAI发布了其全新且免费的AI模型 -- GPT-4o,并宣布即将推出PC桌面版的ChatGPT。

GPT-4o中的“o”代表"Omni"(全能),这是对其强大能力的精确描述。GPT-4o能够实现音频、视觉和文本的实时推断。更具实力的是,它能在232毫秒到320毫秒内对音频输入做出回应,这与人类在对话中的反应速度是相匹配的。

与以往的模型相比,GPT-4o在视觉和音频理解方面展现出了优越性。GPT-4o能够能够在音频、视觉和文本中进行实时推理,接受文本、音频和图像的任何组合作为输入,并生成文本、音频和图像的任何组合进行输出。

OpenAI指出,相较于去年11月发布的GPT-4-turbo,新的GPT-4o将价格降低了50%,同时将速度提升了两倍,也达到了200%。此项降低成本的优化,对于大模型的调用显得尤为重要。这一进步也暗示了OpenAI正在以更缓慢的步伐,逐步将大模型推向市场,而不是仅仅追求技术的冲刺和领先。

OpenAI的CEO,Sam Altman,也在推特上实时发布了自己的观点。他表示,新的GPT-4o是OpenAI迄今为止最好的模型。它具有出色的智能水平,反应速度迅捷,能够进行原生多模态操作。同时,这个新模型将对所有的ChatGPT用户开放,无论他们是否付费获取了GPT-4版。

官方博客介绍:Hello GPT-4o

如何优先获得GPT4o 资格

1.清除你的电脑浏览器缓存

2. 确定你的节点已经解锁了ChatGPT(非常重要,一定要使用原生IP)

3. 全局使用日本或者新加坡节点登录(暂时测试出来这两个地区有效, 评论区可以补充)

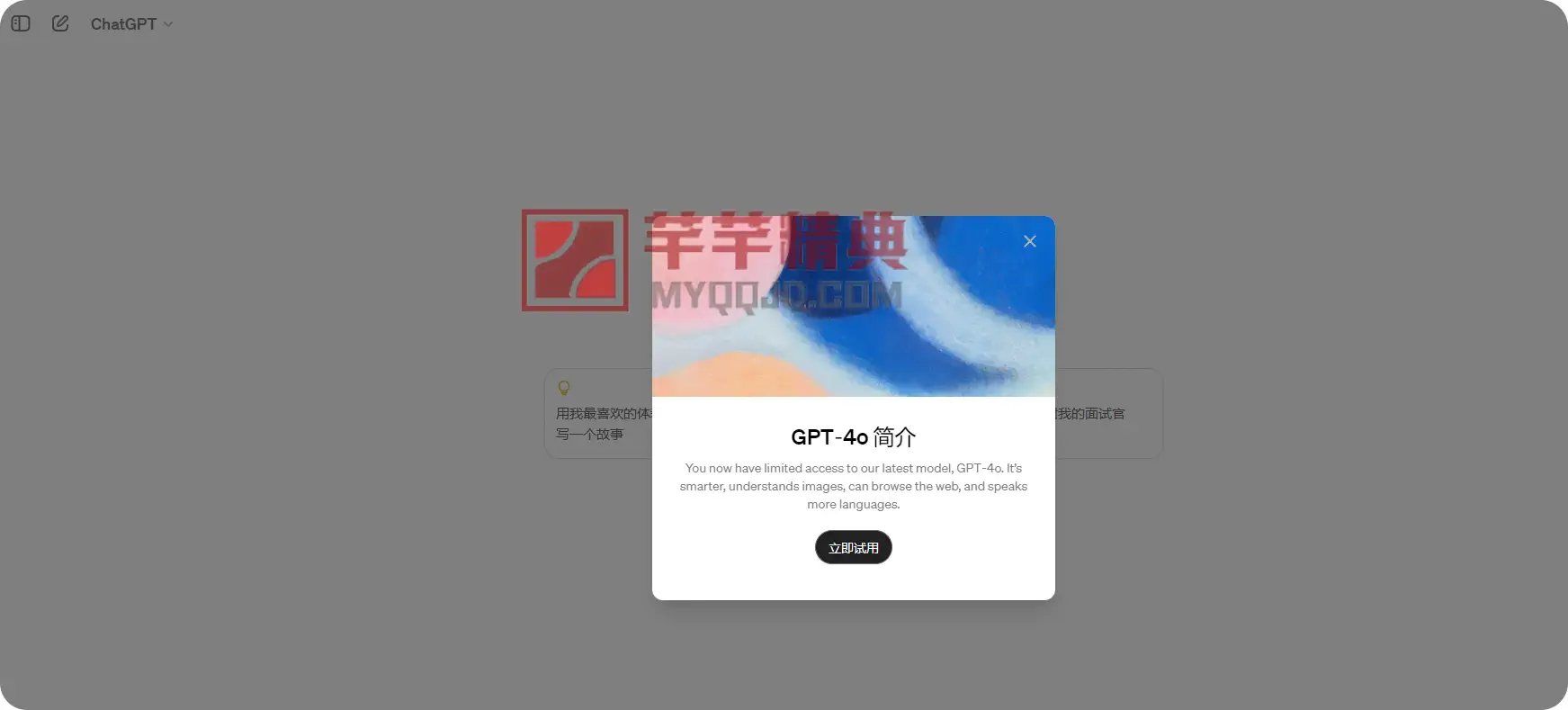

4. 登录后出现下图的弹窗,就表示已经获得资格。

大家可以自测是否有效,不敢保证100%。

辽宁省沈阳市 1F

登录回复

登录就弹窗了,有效

湖南省株洲市 2F

登录回复

谢谢

江苏省南京市 3F

登录回复

好的

福建省泉州市 4F

登录回复

感谢楼主的分享

四川省成都市郫县 5F

登录回复

试试呢

广西南宁市 6F

登录回复

试试能否用

云南省玉溪市 7F

登录回复

感谢分享

江西省萍乡市 8F

登录回复

试试

辽宁省沈阳市沈河区 9F

登录回复

感谢分享

日本东京 10F

登录回复

看下